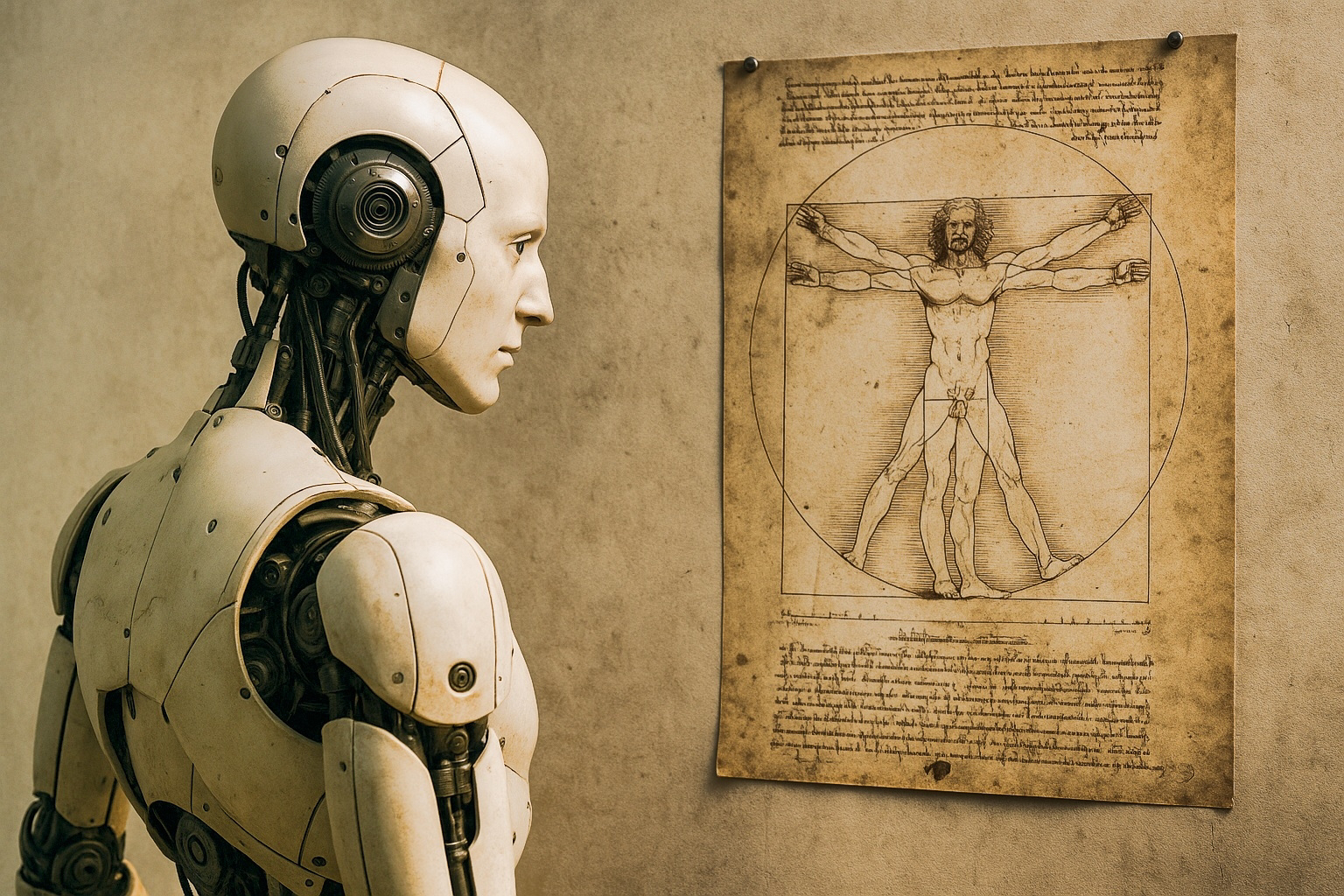

Dimenticate i chip di silicio. Il vero supercomputer – quello che le grandi aziende tecnologiche cercano di emulare – pesa circa 1,5 kg ed è con voi ogni giorno: il vostro cervello.

La struttura e il funzionamento del cervello umano continuano a guidare da oltre mezzo secolo la creazione delle reti neurali, esattamente dalla pubblicazione di Warren S. McCulloch e Walter Pitts, nel 1943, “A Logical Calculus of the Ideas Immanent in Nervous Activity”.

La forza delle connessioni

“Neuroni che si attivano insieme, si collegano insieme” – così recita la legge di Hebb, che spiega come il cervello si riorganizza sulla base dell’esperienza. Imparare qualcosa – come suonare uno strumento o apprendere una lingua – significa rafforzare certe connessioni neurali, creando percorsi preferenziali per l’informazione.

Le reti neurali artificiali imitano tutto ciò con la backpropagation, un algoritmo con cui aggiornano i propri pesi per apprendere dagli errori commessi durante la previsione. “È come un insegnante che interviene costantemente per affinare l’apprendimento,” spiega la neuroscienziata computazionale Sarah Chen. “La rete calcola l’errore e modifica migliaia di connessioni per avvicinarsi alla risposta giusta.”

Imparare con la ricompensa

Ricordiamo meglio ciò che ci colpisce di più. La dopamina, rilasciata in momenti topici, ci aiuta a fissare i ricordi. Le IA di nuova generazione si basano su un principio simile: il reinforcement learning.

Gli algoritmi vengono “premiati” quando si comportano in modo corretto. È così che AlphaGo ha sconfitto i maestri del gioco, e che ChatGPT migliora gradualmente nel fornire risposte pertinenti.

Attraverso l’experience replay questi sistemi rielaborano le esperienze passate, un po’ come avviene nel sonno umano. “In un certo senso, stiamo costruendo macchine che sognano,” osserva provocatoriamente Jürgen Schmidhuber, pioniere del deep learning.

L'attenzione selettiva

In un mondo saturo di stimoli, saper filtrare le informazioni è essenziale.

Il cervello compie questa selezione in modo continuo, scegliendo cosa portare alla coscienza.

Allo stesso modo, i Transformer – l’architettura dietro GPT-4, Claude e Gemini e altre IA generative – utilizzano meccanismi di attention per focalizzarsi sugli elementi rilevanti.

“È come avere un assistente virtuale che sottolinea i passaggi cruciali di una conversazione,” dice Sam Altman, CEO di OpenAI. Questa capacità ha trasformato il campo dell’AI negli ultimi anni.

Troppa memoria può essere un problema

Cervelli e reti neurali possono incorrere nello stesso rischio: ricordare troppo!

Alcune persone nello spettro autistico mostrano una memoria eccezionale ma faticano a cogliere l’insieme. Le IA, invece, rischiano l’overfitting, ovvero una memorizzazione troppo rigida dei dati, che ne limita l’adattabilità.

Per contrastarlo, si impiegano tecniche come il dropout, che disattiva casualmente alcune connessioni durante l’addestramento, o la regolarizzazione, che ne riduce la forza eccessiva.

“È paradossale,” nota Jeff Dean di Google, “ma una rete leggermente 'distratta' si comporta meglio nel mondo reale”.

Conoscenza condivisa

Una delle tecniche più interessanti di apprendimento è la distillazione della conoscenza: un modello più grande insegna a uno più piccolo, trasmettendogli non solo le risposte corrette, ma anche le sfumature dell’incertezza.

“È come un buon insegnante,” dice Ilya Sutskever, co-fondatore di OpenAI. “Non passa solo informazioni, ma anche modi di ragionare.” Un processo che ricorda da vicino il modo in cui noi stessi impariamo.

Verso l’intelligenza artificiale generale

“Le reti neurali, modellate sul cervello, ne ereditano anche i limiti,” osserva Demis Hassabis di DeepMind. “Devono trovare un equilibrio tra memoria e flessibilità, proprio come facciamo noi.”

L’obiettivo più ambizioso perseguito dall’umanità rimane l’Intelligenza Artificiale Generale (AGI), progettata per affrontare e risolvere qualunque tipo di problema, inclusi quelli legati ai più profondi misteri dell’universo.