Nel mio post precedente ho discusso la possibilità di valutare l'efficacia del fine-tuning.

Ho quindi ripreso il modello, già addestrato su diverse attività testuali, per perfezionarlo in un compito specifico: la generazione di descrizioni e riassunti.

Il fine-tuning va fatto con un learning rate relativamente basso (1e-4) per adattare con attenzione i pesi pre-addestrati senza distruggere la conoscenza esistente del modello.

Quando ChatGPT si diffuse in Italia all'inizio del 2023, probabilmente ogni studente sognava di utilizzarla per farsi riassumere gli argomenti delle verifiche.

Ancora oggi, però, per molti le capacità dell'intelligenza artificiale generativa rimangono un mistero.

Chi cerca di approfondire l'argomento si trova spesso a dover interpretare una terminologia tecnica complessa e poco “inclusiva”.

Un esempio è il concetto di “transfer learning”, che possiamo immaginare come il trasferimento di conoscenze da un modello addestrato a un altro.

Un esempio è il concetto di “transfer learning”, che possiamo immaginare come il trasferimento di conoscenze da un modello addestrato a un altro.

Tuttavia, senza competenze tecniche specifiche, risulta difficile comprendere l’implementazione di questo processo, che sembra quasi una pratica occulta.

Per vedere i primi risultati pratici non servono risorse hardware eccezionali: è sufficiente un laptop con una buona scheda NVIDIA e almeno 32 GB di RAM.

Per vedere i primi risultati pratici non servono risorse hardware eccezionali: è sufficiente un laptop con una buona scheda NVIDIA e almeno 32 GB di RAM.

Sono necessarie anche una buona conoscenza del Python e tanta pazienza nel trovare il modo ottimale di far interagire tra loro le varie librerie messe a disposizione dalla vasta comunità mondiale di sviluppatori di reti neurali.

Ogni risultato significativo che ho ottenuto, attraverso numerosi tentativi di esecuzione degli script dal prompt dei comandi di Windows — nei quali definisco il modello di rete neurale, il suo addestramento, salvataggio e testing — è frutto dell'impegno di tante menti brillanti.

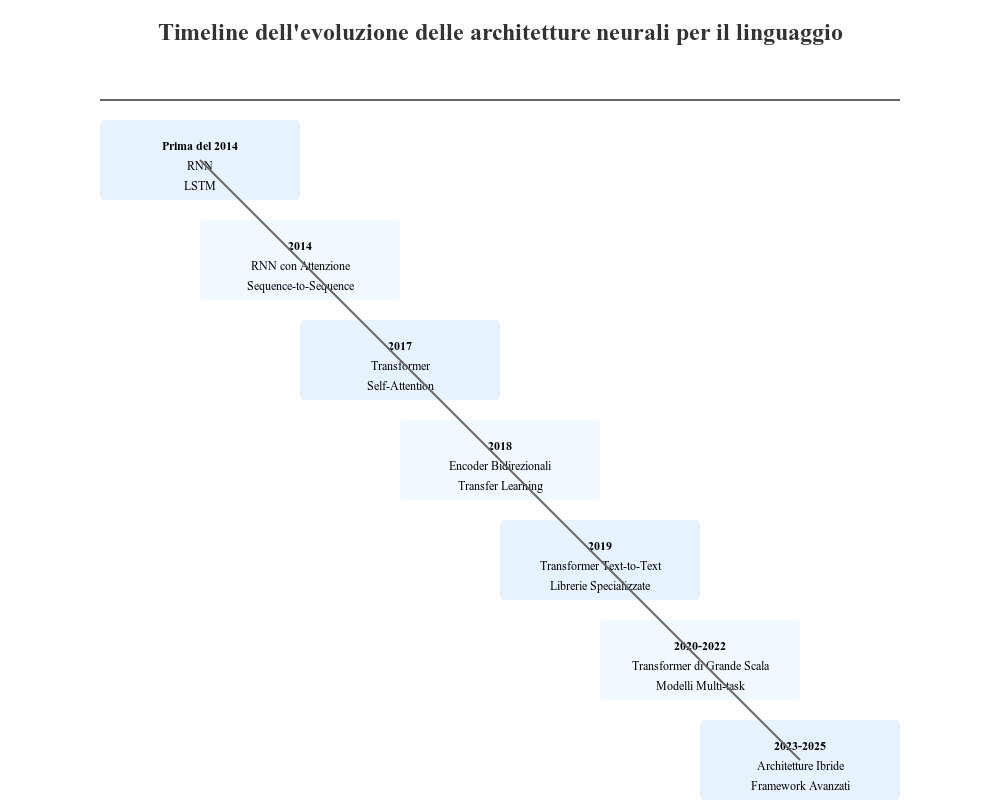

Mi viene in mente l'aforisma “Nani sulle spalle dei giganti”, che intendo illustrare graficamente con una timeline delle scoperte che hanno reso possibili i risultati mostrati nel seguente screenshot della mia console.

Learning rate: iperparametro fondamentale nell'addestramento delle reti neurali.

Controlla quanto velocemente i pesi della rete vengono aggiornati durante l'ottimizzazione.

Un tasso inappropriato pregiudica la qualità dell'apprendimento.

In termini tecnici, provoca la non convergenza della rete neurale.